Testautomatisierung ist nicht gleich Testautomatisierung. Es gibt unterschiedliche Ansätze, die jeweils ihre eigenen Vor- und Nachteile haben.

API- und Unit-Tests laufen in der Regel blitzschnell und ziemlich zuverlässig. Ganz anders sieht es bei Frontend-Tests aus, die reale Nutzeraktionen nachstellen. Während tausende API- oder Unit-Tests in wenigen Minuten durchlaufen, kann ein einziger Frontend-Test schon spürbar länger dauern – einfach, weil Seiten geladen werden und Elemente erst sichtbar sein müssen.

Das sorgt für ein Dilemma: Schnell heißt oft instabil. Stabil heißt oft langsamer.

Die Herausforderung

Frontend-Tests bewegen sich im ständigen Spannungsfeld: Entweder sie laufen zügig, sind dann aber anfälliger für Fehler – oder sie sind robuster, dafür dauert alles länger.

In Teams sorgt das regelmäßig für Diskussionen: Was ist wichtiger – Geschwindigkeit oder Stabilität? Optimal wäre beides – dies zu erreichen, ist allerdings schwer.

Wenn Tests fehlschlagen, muss jedes einzelne Ergebnis geprüft und eventuell erneut gestartet werden. Das kostet Zeit und Nerven. Hinzu kommen Faktoren wie Netzwerkprobleme, lange Ladezeiten oder Ladeanimationen, die Tests zusätzlich ausbremsen. Wer unnötige Fehlermeldungen vermeiden will, muss die Geschwindigkeit zwangsläufig etwas reduzieren.

Was bedeutet Stabilität eigentlich?

„Stabil“ klingt eindeutig – ist es aber nicht. Heißt das, dass Tests wirklich zu 100 % fehlerfrei laufen – und das jeden Tag? Oder reicht hier schon eine Erfolgsquote von 95 %?

Im Kern sollte ein Test nur dann fehlschlagen, wenn auch wirklich ein Fehler im System steckt. Das Problem: Dafür müssten System und Testumgebung ebenfalls absolut stabil laufen. Und das ist in der Praxis kein realistisches Szenario.

Und was heißt „schnell“?

Auch Geschwindigkeit ist relativ. Ein einfacher Check auf der Startseite ist nun mal schneller als ein komplexer Workflow mit Login und mehreren Schritten. Nicht jeder Test muss unter 20 Sekunden liegen, um als „schnell“ zu gelten. Liegt der Durchschnitt bei rund 30 Sekunden, ist das schon ziemlich effizient – vor allem, wenn man Tests parallel laufen lässt.

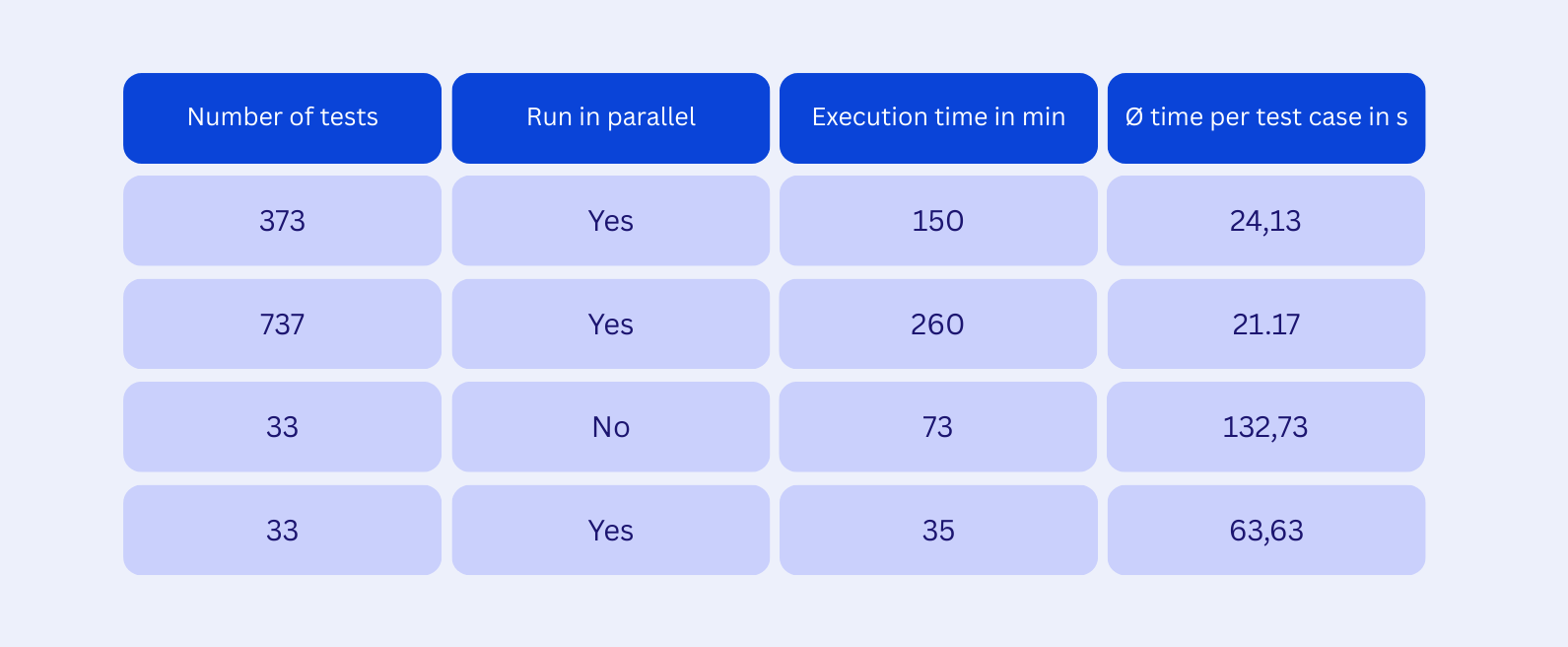

Beispiele:

Wie lässt sich das Zusammenspiel verbessern?

Um Tests zu beschleunigen, gibt es verschiedene Kniffe: parallele Ausführung, Mocking von Komponenten, Set-ups per API oder direktes Aufrufen von URLs statt reale Klicks. Das spart Zeit, bildet aber nicht immer das reale Nutzerverhalten ab – und kann dadurch Probleme überdecken.

Stabilität wiederum lässt sich verbessern, indem man Wiederholungen einbaut, kleine Pausen zwischen Schritten zulässt oder sogar das Testframework wechselt. Doch das macht die Tests oft noch langsamer oder bedeutet viel Zusatzaufwand, besonders bei großen Test-Suites.

Der richtige Weg ist ein schmaler Pfad

Die Kunst besteht darin, Tests so schnell wie möglich zu halten, ohne dabei Stabilität zu opfern. Das gelingt nur durch kontinuierliche Optimierung – angepasst an System und Umgebung. Manchmal heißt das auch: akzeptieren, dass Tests eben nicht ultraschnell sind.

Aber: Zu langsam darf es nicht werden. Wenn 500 Testfälle jeweils eine Minute brauchen und nicht parallelisiert werden können, dauert der Durchlauf über 8 Stunden. Spätestens dann ist klar: Nach jedem Deployment alle Tests laufen zu lassen, ist keine Option.

Das Lean-Prinzip empfiehlt, Verschwendung zu vermeiden, Kundennutzen zu maximieren und Prozesse stetig zu verbessern. Genau deshalb ist es wichtig, die wichtigsten automatisierten Tests so stabil und gleichzeitig so effizient wie möglich zu gestalten.

Am Ende geht es um Balance: lieber etwas längere Laufzeiten in Kauf nehmen, dafür aber sehr zuverlässige Ergebnisse. Mit guter Parallelisierung verliert die Gesamtdauer ohnehin an Schrecken – auch wenn sie mit wachsender Testanzahl zwangsläufig steigt.

Fazit

Jedes Projekt ist individuell und braucht seinen eigenen Weg. Es gilt: Tests möglichst stabil gestalten und die Geschwindigkeit durch Parallelisierung oder frühere Runs verbessern. Dies kann ein bisschen länger dauern – dafür sind die Ergebnisse verlässlich. Schnelle, aber fehleranfällige Tests kosten auf Dauer nur mehr Zeit.

Unsere Expert:innen unterstützen Sie gern dabei!